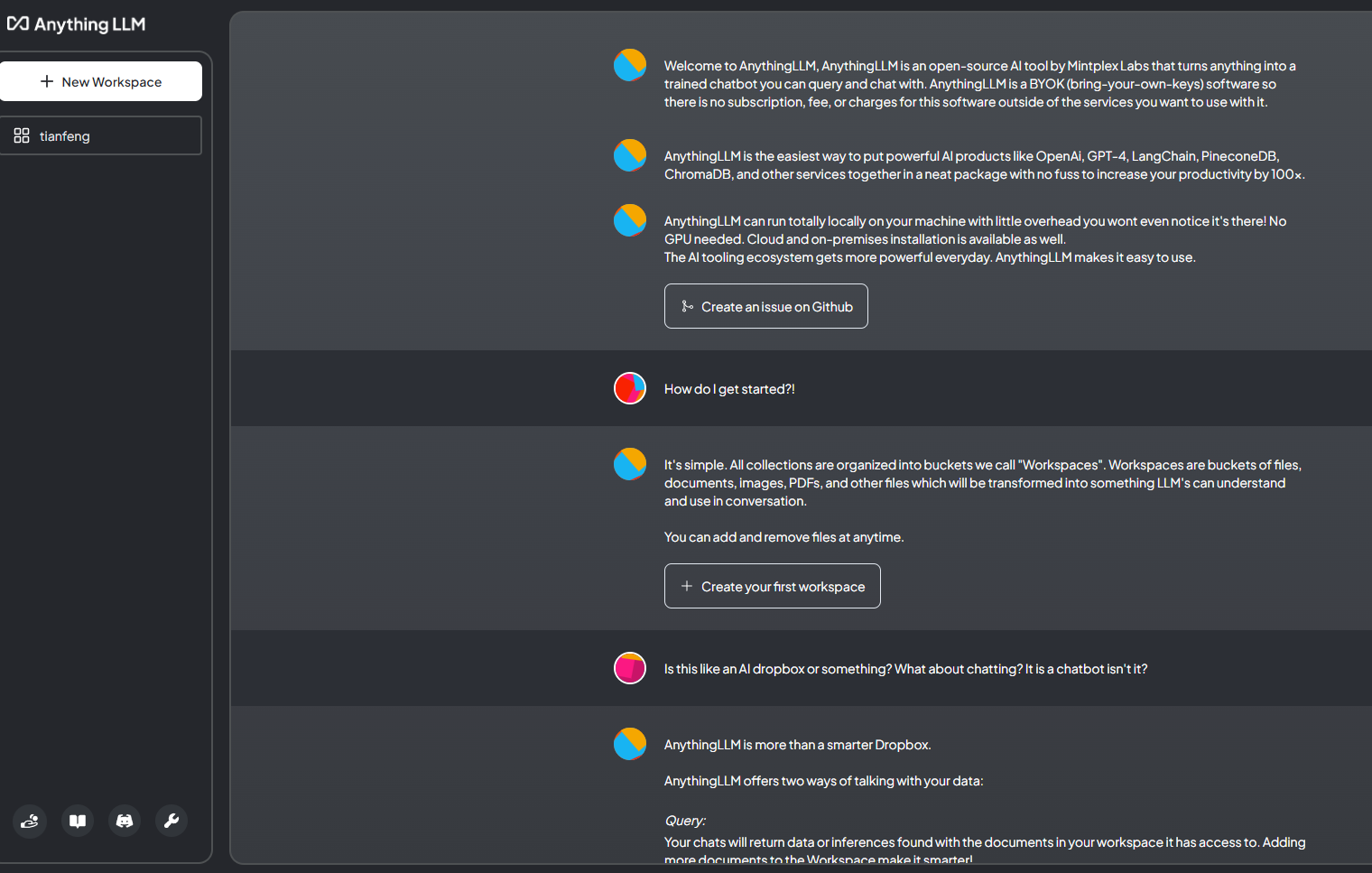

这是一个全栈应用程序,可以将任何文档、资源(如网址链接、音频、视频)或内容片段转换为上下文,以便任何大语言模型(LLM)在聊天期间作为参考使用。此应用程序允许您选择使用哪个LLM或向量数据库,同时支持多用户管理并设置不同权限。

-

工作区内的智能体Agent(浏览网页、运行代码等)

-

支持多种文档类型(PDF、TXT、DOCX等)

-

通过简单的用户界面管理向量数据库中的文档

-

两种对话模式:

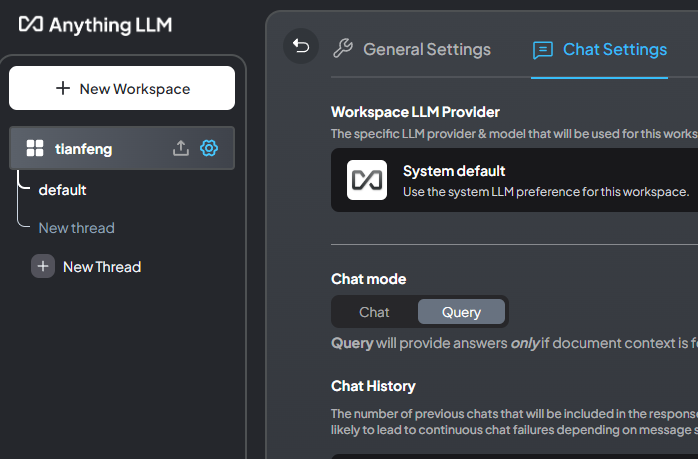

聊天和查询。聊天模式保留先前的对话记录。查询模式则是是针对您的文档做简单问答 -

聊天中会提供所引用的相应文档内容

-

管理超大文档时高效、低耗。只需要一次就可以嵌入(Embedding)一个庞大的文档或文字记录。比其他文档聊天机器人解决方案节省90%的成本。

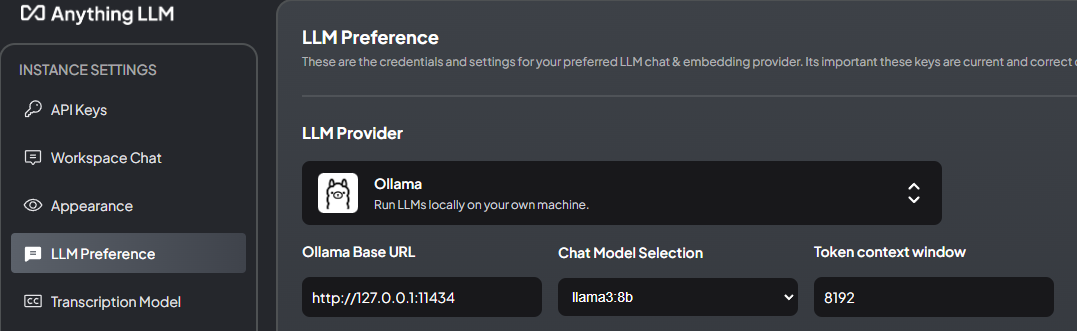

使用Ollama下载大模型,向量模型等,AnythingLLM作为webui可视化

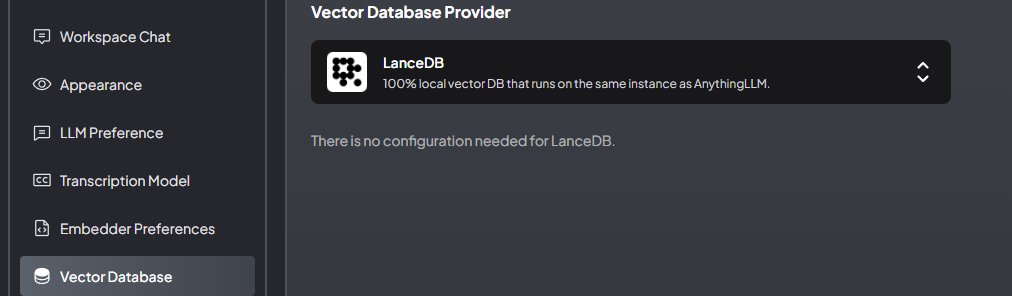

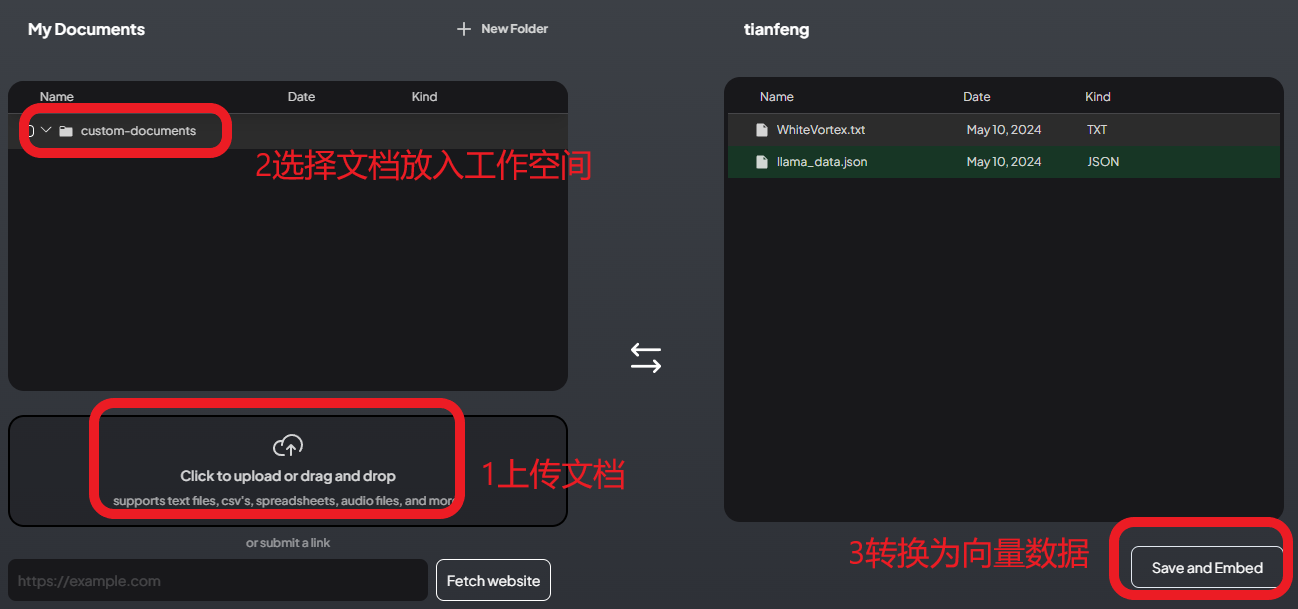

整体流程就是上传文档-->>经过embedding模型转化为向量数据-->>选择向量数据库如(LanceDB)存储-->>根据问题调用大模型读取本地向量库匹配答案输出

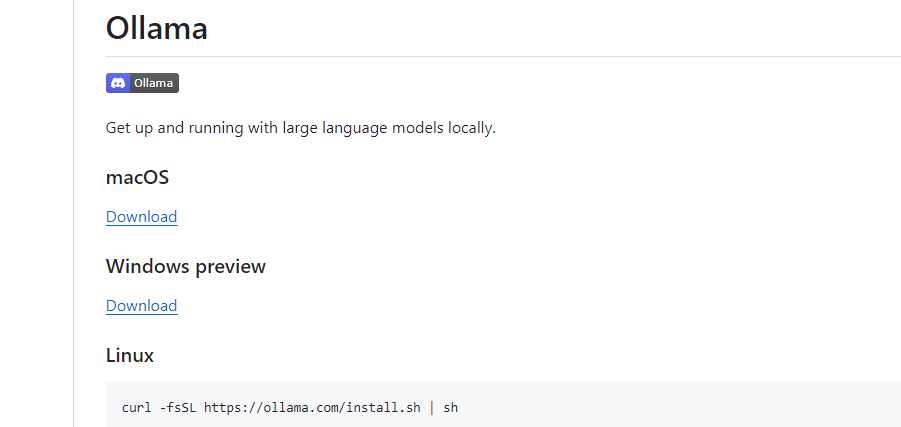

ollama

https://github.com/ollama/ollama?tab=readme-ov-file

选择对应系统安装

安装打开ollama后cmd命令行窗口,运行

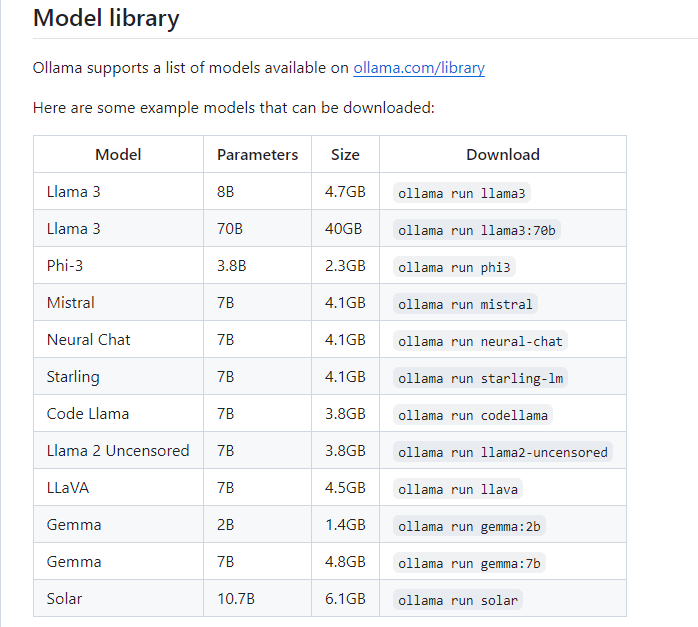

ollama run llama3 #下载Llama3 8b ollama run llama3:70b #下载Llama3 70b 参考下图 ollama pull nomic-embed-text #下载向量模型 ollama.com/library

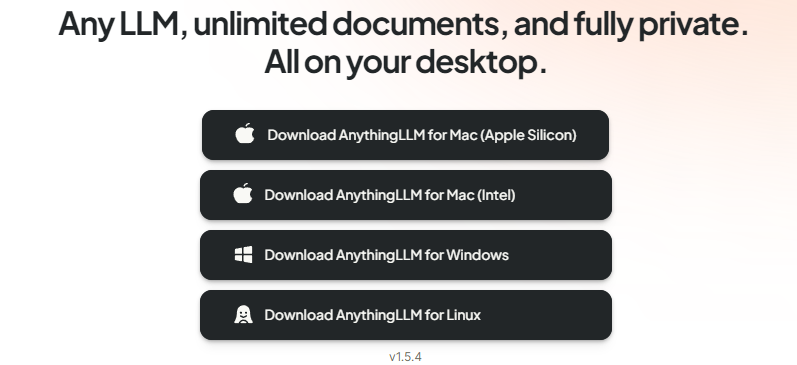

anything-llm

https://github.com/Mintplex-Labs/anything-llm/tree/master

https://useanything.com/download

下载对应版本

C:\Users\admin\AppData\Roaming\anythingllm-desktop\storage\models\ 模型保存文件处

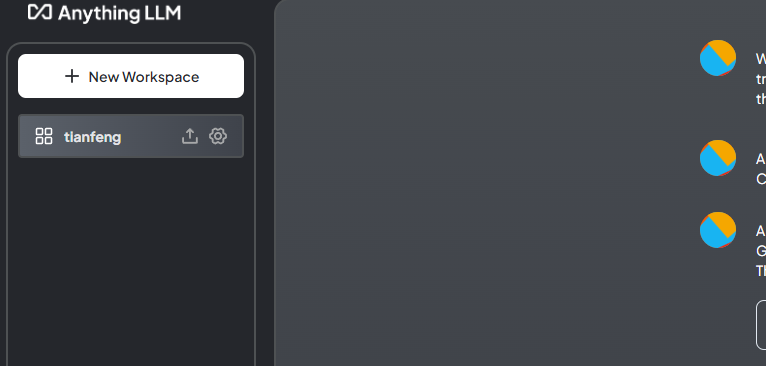

左下角点击扳手,设置模型,embedding模型,向量数据库

上传本地文档,点击上传按钮

点击设置按钮,选择Query,即为从本地文档检索数据回答

相关文章

我的公众号

微信扫一扫

评论